Actualités 2012

Une équipe commune du service de physique nucléaire et du service des détecteurs, d’électronique et d’informatique de l’IRFU (SPhN et Sédi) a récemment montré que la nouvelle génération de détecteurs Micromegas pouvait être utilisée dans l’air atmosphérique. Grâce à la technologie des pistes résistives mise au point par le CERN, ce détecteur atteint en effet des gains d’amplification de 2 à 5 fois supérieurs à un Micromegas standard. Un premier spectre d’une source radioactive (Fe55) a été obtenu, et une détection de rayonnements cosmiques a été mise en évidence. L’utilisation de ce détecteur sans aucun système de gaz, souvent contraignant, pourrait ouvrir de nouvelles possibilités d’applications, par exemple dans l’imagerie ou la dosimétrie.

Les travaux de cette étude ont fait l’objet d’un article accepté en juin à publication dans Nuclear Instruments and Methods in Physics.

Contexte

Les détecteurs gazeux ont joué un rôle majeur dans l’histoire de la détection de particules, depuis l’invention de la chambre à brouillard par Wilson il y a un siècle. De nos jours, des chambres proportionnelles multi-fils, des chambres à dérive, ainsi que des détecteurs à micro-pistes équipent la plupart des grandes expériences de physique à travers le monde. L’une des dernières générations de ces détecteurs est le Micromegas, dans lequel l’amplification du signal est réalisée entre le plan d’anode (pistes) et une micro-grille. Ce détecteur présente l’avantage d’être très résistant à des flux de particules élevés, et moins cher que des détecteurs solides type Silicium pour des surfaces beaucoup plus grandes. Ses performances l’ont également rendu attractif pour de nombreuses applications en dehors de la physique fondamentale, comme l’imagerie médicale ou récemment la détection d’incendies de forêts.

Dans tous les cas, ces détecteurs doivent être remplis avec un gaz approprié, ce qui implique généralement l’installation et la maintenance d’un système de gaz et éventuellement la mise en place de règles de sécurité (afin de parer aux risques d’inflammabilité ou d’anoxie). En pratique, l’air « simple » n’est jamais utilisé car il ne permet pas une amplification suffisante des charges, en raison de la forte probabilité de recombinaison des électrons avec les atomes d’oxygène de l’air. Une plus grande amplification nécessiterait des tensions électriques plus élevées. Or ce régime est instable et se traduit par l’apparition de claquages entre les bornes du détecteur.

La version anglaise du film ‘L’Univers Recalculé’ produit à l’Irfu par l’équipe COAST (projet conjoint SAp/Sedi) a été sélectionnée, avec 16 autres films sur 26 propositions, pour faire partie du ‘scientific visualization showcase’ projeté lors de la conférence SuperComputing 2012 du 10 au 16 novembre à Salt Lake City.

Cette sélection des films a été présentée au Salt Palace Convention Center le mardi 13 novembre aux participants de SC12 ; il s’agit de films sur la visualisation de résultats de simulations numériques issus de calculs Haute Performance dans différents domaines de recherche en physique.

SuperComputing est la plus importante manifestation dans le domaine du Calcul Haute Performance ; elle a lieu tous les ans en novembre aux Etats-Unis et réunit des milliers de participants dans un immense espace d’exposition et de conférences. C’est à l’occasion de SC qu’est remise à jour la fameuse liste TOP500 des plus grosses machines parallèles dans le monde.

Description du film (version française)

Contact Irfu/Sedi : Bruno Thooris

Le Comité des Programmes Scientifiques (SPC) de l’ESA vient d’approuver le démarrage de la mission Euclid consacrée à l’étude de l’énigmatique énergie noire. Cette étape très importante est la dernière d’un processus de près de cinq ans qui aura vu Euclid, née d’une idée française, franchir avec succès toutes les étapes de sélection pour être retenue, parmi plus de 50 propositions à l’origine, comme deuxième mission du programme Vision Cosmique de l’ESA. La France, à travers le CNES (l’agence spatiale française), le CNRS et le CEA [1], a initié ce projet et contribue de manière déterminante à sa réalisation. Le lancement est prévu au second trimestre 2020.

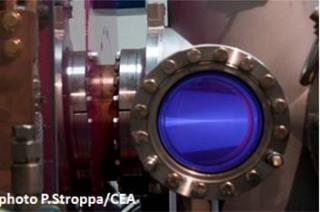

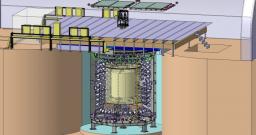

En novembre 2012, sous la direction des équipes impliquées du SACM et du SIS, l’Injecteur IFMIF a atteint les performances demandées, tant sur le plan des caractéristiques du faisceau que sur le plan de la gestion des sécurités machine et personnel. Les résultats obtenus ont permis d’atteindre une puissance record pour un tel faisceau : en mode continu, à la sortie de l’injecteur, le courant d’ions Deuterium D+ a atteint 140 mA (soit 14 kW). Le transfert de l’Injecteur sur le site de Rokkasho, au Japon, est en cours avec une arrivée prévue début de 2013 au Japon. L’Injecteur sera le premier élément de l’accélérateur qui sera installé sur le site Japonais.

Dans le cadre de l'Approche élargie d'Iter, l’Irfu est chargé de mettre en œuvre la contribution française au projet Ifmif (International Fusion Materials Irradiation Facility), qui permettra de tester les matériaux développés pour les futures installations de fusion nucléaire.

L’Irfu doit concevoir et construire à l’échelle 1 un démonstrateur de la partie à basse énergie (jusqu’à 9 MeV) de l'accélérateur d’Ifmif, en particulier l’injecteur et le linac supraconducteur.

Depuis l’installation de l’injecteur en mai 2011 différentes étapes ont été franchies avec le faisceau de protons :

- en mode pulsé, des intensités exceptionnelles de 150 mA ont été atteintes ;

- en mode continu, 100 mA d’ions hydrogène a été produit et guidé dans la ligne de transport à une énergie de 75 keV.

- En juin 2012, le premier faisceau d’ions deutérium a été produit en mode pulsé et récemment, le courant extrait de la source a atteint 125 mA avec une énergie de 100 keV et un cycle utile de 1 % (10 ms/1 s).

Avec des faisceaux aussi intenses le « conditionnement » est une étape très délicate. Il faut s’assurer que le faisceau (d’une puissance de plusieurs kW !) est bien optimisé et ne vient toucher aucun composant délicat, sous peine de faire fondre celui-ci.

Après une montée très progressive en puissance, l’injecteur Ifmif est désormais opérationnel pour entrer dans la phase de caractérisation du faisceaux de protons et de deutons.

contact: Raphaël Gobin

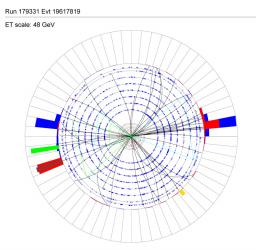

Les expériences ALICE et CMS ont levé un coin du voile sur la matière ultrachaude créée au sein des collisions d'ions lourds du LHC, analogue au plasma de quarks et de gluons baignant l'Univers quelques microsecondes après le Big Bang. La particule J/psi au charme caché n'a pas fini de jouer un rôle dans cette saga. Sa suppression est une des pistes suivies afin de caractériser expérimentalement ce milieu. ALICE et CMS détectent le J/psi dans deux gammes d'énergies complémentaires. Leurs résultats, mis en relief par les ceux des expériences pionnières, sont surprenants. Ils laissent présager un régime en température et en densité d'énergie du plasma si différent au LHC que le J/psi s'y verrait en partie régénéré. L'investigation se poursuit en ce moment même. Une affaire à suivre…

Les collaborations ALICE et CMS ont soumis mi mars pour publication leurs articles sur la suppression des quarkonia observée dans les collisions d'ions lourds au LHC (CERN, Suisse). Les quarkonia désignent à la fois les états liés d'un quark charme (c) et de son antiquark (cbar), et ceux d'un quark beau (b) et de son antiquark (bbar).

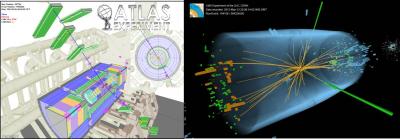

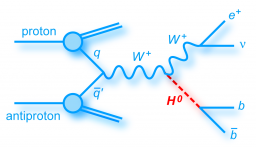

Les résultats préliminaires obtenus par les expériences Atlas et CMS du Grand Collisionneur de Hadrons (LHC) dans le cadre de la recherche du boson de Higgs indiquent l'existence d'une nouvelle particule dans la région de masse autour de 126 GeV. Il s'agit d'un boson dont les caractéristiques sont compatibles avec celles du célèbre boson de Higgs. Bien que des analyses complémentaires soient nécessaires pour en établir la nature exacte, cette découverte représente une étape cruciale dans la compréhension de l'univers et de la matière.

"C est une découverte majeure telle que l on en voit que quelques unes par siècle", déclare Philippe Chomaz chef de l'Irfu.

"Le LHC, CMS et ATLAS correspondent à un investissement majeur de la communauté internationale dans lequel l ensemble de l irfu contribue fortement. Je tiens à saluer l extraordinaire investissement de chacun dans cette aventure qui ne fait que commencer avec la découverte de ce nouveau continent inconnu : le secteur du Higgs.

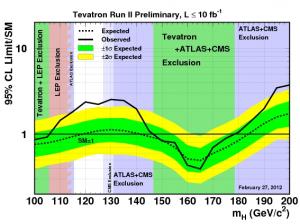

Lors des conférences de mars 2012, les physiciens du Tevatron et du LHC ont dévoilé les derniers résultats sur leur recherche du bosons de Higgs.

Le domaine encore permis pour la masse du boson de Higgs est maintenant réduit à un intervalle de 10 GeV aux alentours de 120 GeV.

Après les premières analyses de l'ensemble des données enregistrées par le Tevatron, les collaborations CDF et D0 ont trouvé un excès d'événements entre 115 et 135 GeV. Même si cet excès peut être encore interprété comme une fluctuation statistique, il est compatible avec un excès similaire observé autour de 125 GeV par les expériences ATLAS et CMS avec les données du LHC accumulées jusqu'en 2011.

Higgs Wanted

Le boson de Higgs est la pierre angulaire manquante du modèle standard de la physique des particules. Recherché depuis plus de 20 ans, cette particule, si elle existe, permettrait de donner une masse à toutes les autres particules.

Sans quelque chose comme le boson de Higgs qui donne une masse aux particules élémentaires, le monde serait extrêmement différent de ce qu'il est. Par exemple il ne pourrait pas exister d'atome pour former des planètes ou des êtres vivants.

Découvrir ce boson permettrait, outre l'achèvement de la description du modèle standard, d'obtenir des informations précieuses sur l'existence d'éventuelles particules ou forces au delà du modèle standard.

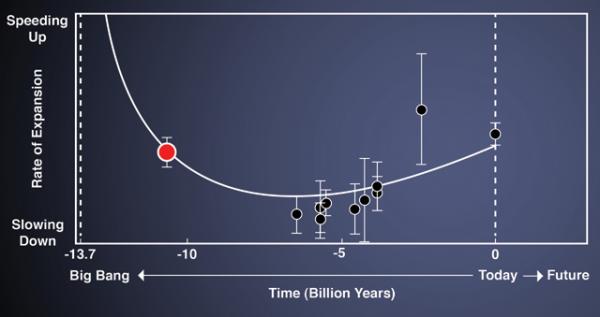

Des astrophysiciens du projet SDSS-III (Sloan Digital Sky Survey), composé en grande partie de chercheurs français, du CEA Irfu et du CNRS In2p3 et INSU, ont effectué la première mesure du taux de l’expansion de l’Univers jeune, âgé de seulement trois milliards d’années sur ces 13,7 milliards, alors que la gravité freinait encore son expansion, avant sa phase actuelle d'expansion accélérée par l'Energie Noire. Ils ont utilisé pour cela une nouvelle technique permettant de dresser une carte en trois dimensions de l’Univers lointain. Ce résultat est en ligne sur arXiv.org.

Différentes phases de l'expansion de l'Univers

Hubble et Lemaître ont mis en évidence l’expansion de l’Univers dans les années 1920 en procédant à deux types de mesures pour un même ensemble de galaxies : la distance entre ces galaxies et nous, ainsi que la vitesse de ces galaxies (en utilisant l’effet Doppler sur les raies de leurs spectres).

Leurs observations sont à l'origine du modèle "standard" actuel de la cosmologie. Pendant la plupart de l’histoire de l’Univers, cette expansion n’a cessé de ralentir, sous l'effet de la gravitation de matière et de la radiation. Mais depuis cinq milliards d'années, quand l’Univers avait environ 7 milliards d’années, ce comportement s'est inversé : l'expansion s'est mise à accélérer, probablement sous l'effet d'une mystérieuse force répulsive produite par ce qu’on a appelé : "l'énergie sombre". Des expériences en cosmologie ont permis d’observer cette période d'accélération récente, mais pas la décélération primitive de l’Univers. Réussir à mesurer cette décélération exige de remonter aux premiers milliards d’années de son histoire, de remonter loin dans le temps, donc d’observer loin dans l’espace. Pour cela, des galaxies ne suffisent plus : à des distances aussi élevées, leur luminosité devient trop faible.

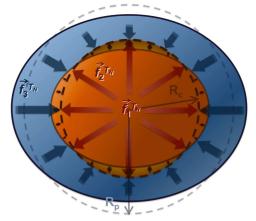

Deux chercheurs de l’Université Nice Sophia Antipolis - Observatoire de la Côte d’Azur, de l’Université Paris Diderot et du CEA, viennent de proposer le premier modèle expliquant l’origine de la grande majorité des satellites réguliers [1] de notre système solaire. D’abord testé en 2010 sur les lunes de Saturne, ce modèle unique expliquerait aujourd’hui la répartition des nombreux satellites des planètes dites « géantes », et permettrait également d’expliquer la présence des satellites autour des planètes dites « terrestres » telles que la Terre ou Pluton. Pour toutes ces planètes, leurs satellites seraient bien nés à partir d'anneaux aujourd'hui disparus. Ces résultats sont déterminants pour comprendre et expliquer de manière universelle la formation des systèmes planétaires. Ces travaux sont publiés le 30 novembre 2012 dans la revue Science.

Observés depuis le milieu du XVIIe siècle, on pensait les mouvements des principaux satellites de Saturne parfaitement connus. Pourtant, en utilisant plus d'un siècle d'observations précises, une équipe internationale menée par des chercheurs de l'Observatoire de Paris, de l'UPMC, du Service d'Astrophysique-AIM du CEA/IRFU et de l'Université Paris Diderot a mis en évidence de petites accélérations associées aux effets de marées produits par chacun des satellites sur Saturne. Jusqu'alors considérés comme faibles, ces effets de marées s'avèrent dix fois plus forts que prévu, expliquant probablement l'origine des geysers observés par la mission CASSINI sur le satellite Encelade. Mais ces résultats ébranlent du même coup certaines de nos connaissances concernant ce système, telles que les mécanismes physiques en action à l'intérieur de la planète ou encore le processus de formation même des satellites. Ces résultats sont publiés dans les numéros de juin 2012 des revues The Astrophysical Journal et Astronomy & Astrophysics et dans le numéro de décembre de la revue Icarus.

Les résultats préliminaires obtenus par les expériences Atlas et CMS du Grand Collisionneur de Hadrons (LHC) dans le cadre de la recherche du boson de Higgs indiquent l'existence d'une nouvelle particule dans la région de masse autour de 126 GeV. Il s'agit d'un boson dont les caractéristiques sont compatibles avec celles du célèbre boson de Higgs. Bien que des analyses complémentaires soient nécessaires pour en établir la nature exacte, cette découverte représente une étape cruciale dans la compréhension de l'univers et de la matière.

"C est une découverte majeure telle que l on en voit que quelques unes par siècle", déclare Philippe Chomaz chef de l'Irfu.

"Le LHC, CMS et ATLAS correspondent à un investissement majeur de la communauté internationale dans lequel l ensemble de l irfu contribue fortement. Je tiens à saluer l extraordinaire investissement de chacun dans cette aventure qui ne fait que commencer avec la découverte de ce nouveau continent inconnu : le secteur du Higgs.

Lors des conférences de mars 2012, les physiciens du Tevatron et du LHC ont dévoilé les derniers résultats sur leur recherche du bosons de Higgs.

Le domaine encore permis pour la masse du boson de Higgs est maintenant réduit à un intervalle de 10 GeV aux alentours de 120 GeV.

Après les premières analyses de l'ensemble des données enregistrées par le Tevatron, les collaborations CDF et D0 ont trouvé un excès d'événements entre 115 et 135 GeV. Même si cet excès peut être encore interprété comme une fluctuation statistique, il est compatible avec un excès similaire observé autour de 125 GeV par les expériences ATLAS et CMS avec les données du LHC accumulées jusqu'en 2011.

Higgs Wanted

Le boson de Higgs est la pierre angulaire manquante du modèle standard de la physique des particules. Recherché depuis plus de 20 ans, cette particule, si elle existe, permettrait de donner une masse à toutes les autres particules.

Sans quelque chose comme le boson de Higgs qui donne une masse aux particules élémentaires, le monde serait extrêmement différent de ce qu'il est. Par exemple il ne pourrait pas exister d'atome pour former des planètes ou des êtres vivants.

Découvrir ce boson permettrait, outre l'achèvement de la description du modèle standard, d'obtenir des informations précieuses sur l'existence d'éventuelles particules ou forces au delà du modèle standard.

En préparation de la conférence ICHEP 2012 à Melbourne, les physiciens du Tevatron ont présenté les derniers résultats sur leur recherche du boson de Higgs, le 2 juillet. Les analyses mettent en avant un excès d'événements très marqué pour des masses possibles du boson de Higgs entre 115 et 135 GeV dans le canal de désintégration du Higgs en b+anti-b peu accessible au LHC. Cet excès peut soit s'interpréter comme une indication de la présence du boson de Higgs, soit comme une fluctuation statistique du bruit de fond. La précision des résultats, en combinant les deux expériences CDF et D0, se traduit par le fait que ce signal a une chance sur 550 qu’il soit due à une fluctuation statistique. L'excès d'événements du Tevatron est compatible avec la nouvelle particule observée autour de 125 GeV par les expériences ATLAS et CMS au CERN pour l’ouverture de la conférence ICHEP 2012.

Lors des conférences de mars 2012, les physiciens du Tevatron et du LHC ont dévoilé les derniers résultats sur leur recherche du bosons de Higgs.

Le domaine encore permis pour la masse du boson de Higgs est maintenant réduit à un intervalle de 10 GeV aux alentours de 120 GeV.

Après les premières analyses de l'ensemble des données enregistrées par le Tevatron, les collaborations CDF et D0 ont trouvé un excès d'événements entre 115 et 135 GeV. Même si cet excès peut être encore interprété comme une fluctuation statistique, il est compatible avec un excès similaire observé autour de 125 GeV par les expériences ATLAS et CMS avec les données du LHC accumulées jusqu'en 2011.

Higgs Wanted

Le boson de Higgs est la pierre angulaire manquante du modèle standard de la physique des particules. Recherché depuis plus de 20 ans, cette particule, si elle existe, permettrait de donner une masse à toutes les autres particules.

Sans quelque chose comme le boson de Higgs qui donne une masse aux particules élémentaires, le monde serait extrêmement différent de ce qu'il est. Par exemple il ne pourrait pas exister d'atome pour former des planètes ou des êtres vivants.

Découvrir ce boson permettrait, outre l'achèvement de la description du modèle standard, d'obtenir des informations précieuses sur l'existence d'éventuelles particules ou forces au delà du modèle standard.

Les dernières analyses de la collaboration D0 au Tevatron ont atteint une précision inégalée comme par exemple 1,8% sur la masse du quark top dans une voie de désintégration particulière avec deux leptons (comme des électrons ou des muons). Les physiciens du groupe D0 du SPP ont publié, dans différentes revues scientifiques, quatre nouvelles mesures confirmant les prédictions du modèle standard. Ces mesures utilisent, pour le moment, la moitié de la statistique accumulée au Tevatron par l’expérience. Elles se poursuivront jusque fin 2012 et permettront peut-être de découvrir, une contribution possible de physique au-delà du modèle standard.

Le quark top, un cas particulier dans la famille des quarks

Le quark top est une particule unique qui suscite la curiosité des physiciens depuis toujours. Dès qu’il est créé, il se désintègre alors que les autres quarks une fois créés, se retrouvent immédiatement confinés avec d’autres quarks et des gluons pour former un état lié (appelé hadron). Ce confinement engendre une inconnue supplémentaire dans la reconstruction des processus élémentaires. Ainsi les observables de la physique du quark top sont plus faciles à modéliser. Du fait de sa grande masse, le quark top est également une sonde particulièrement sensible aux phénomènes nouveaux.

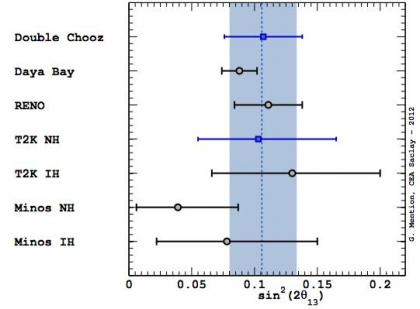

La 25e conférence internationale bisannuelle de physique des neutrinos vient de se tenir à Kyoto au Japon au début du mois de juin 2012. Les nouvelles mesures du troisième angle de mélange de la matrice des neutrinos, θ13, ont tenu la vedette et c’est une pluie fertile de résultats expérimentaux qui s’est abattue sur la conférence.

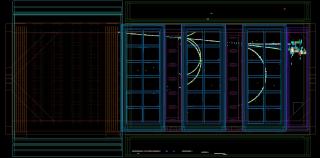

Le projet Double-Chooz a produit en fin 2011 le rapport technique de conception de son deuxième détecteur. C’est un document de référence qui définit chacun des lots techniques du détecteur et leurs interfaces. Ce document sous la coordination technique de l’Irfu est le fruit d'un travail des 35 instituts du projet, nécessitant de ce fait des échanges techniques efficaces. Une revue technique les 12 et 13 janvier 2012 à Saclay est venue parachever ce travail. l’objectif est à présent d’assembler ce détecteur deux fois plus vite que le premier pour qu'il soit opérationnel début 2013.

Rappel du contexte de l'expérience

Le projet Double-Chooz, constitué de deux détecteurs identiques, a pour objectif de mesurer la valeur de l’angle de mélange θ13 caractérisant l’oscillation des anti-νe provenant des réacteurs nucléaires situés à la centrale de Chooz dans les Ardennes. Un premier détecteur (dit « lointain » car situé à 1 km des cœurs) a été réalisé et est en fonctionnement depuis plus d’un an maintenant (actualité de décembre 2010 ).

La réalisation d’un deuxième détecteur (dit « proche », à 400 m des cœurs) est nécessaire afin d’améliorer la qualité de la mesure en diminuant les erreurs systématiques.

D’autres expériences sont aussi en quête de la valeur de l’angle de mélange θ13. Le projet complémentaire T2K au Japon, mais aussi deux expériences de conception très similaire à Double-Chooz, celles situées sur le site de Daya Bay (Chine) et RENO (Corée).

"Après la présentation des premiers résultats de Double Chooz en fin d’année 2011 (actualité de novembre 2011), il faut donc faire vite pour maintenir notre place dans la détermination précise de la valeur de θ13." assure Christian Veyssière, chef de projet de l'expérience Double chooz à l'Irfu.

L’expérience appelée GBAR (Gravitational Behaviour of Antihydrogen at Rest), vise à observer la chute d’atomes d’antimatière formés à l’aide d’un accélérateur de particules, afin de vérifier s’ils se comportent comme la matière habituelle. Cette mesure est un test important du principe d’équivalence d’Einstein et des symétries fondamentales de l’Univers.

L’équipe menée par P.Pérez de l’Irfu/SPP, qui travaille depuis 7 ans à la conception de l’expérience, vient de voir ses efforts couronnés : le mercredi 18 janvier 2012 le Conseil scientifique de l’accélérateur SPS du Cern a décidé de recommander la proposition d’expérience GBAR. Les premières prises de données devraient avoir lieu en 2016.

L’expérience H.E.S.S (High Energy Stereoscopic System) en opération avec 4 télescopes à effet Cherenkov atmosphérique depuis 2004 entre dans une deuxième phase avec le démarrage d'un cinquième télescope, le plus grand construit à ce jour. Cette nouvelle phase va ouvrir une nouvelle fenêtre d’exploration du ciel de l’hémisphère Sud et va permettre de découvrir de nouvelles classes de sources de rayons gamma de hautes énergies (trous noirs supermassifs, pulsars, sursauts gammas,…) ainsi que de sonder les lois de fondamentales de la nature (matière noire, invariance de Lorentz,…). Le groupe de l’IRFU a conçu et développé les mémoires analogiques S.A.M. (Swift Analogue Memory) ainsi qu’un système de déclenchement de niveau 2 pour accéder aux énergies aussi basses qu’une vingtaine de GeV.

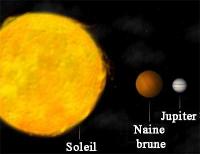

Une équipe dirigée par Philippe André du Service d'Astrophysique-Laboratoire AIM du CEA-Irfu vient de découvrir la toute première étape de la formation d'une naine brune, une de ces étoiles de très faible masse, à peine plus massive qu'une planète. Plusieurs centaines de ces naines brunes sont aujourd'hui connues mais jusqu'ici jamais il n'avait été possible d'observer le début de la formation de ces micro-étoiles. Grâce à l'interféromètre de l'IRAM observant en ondes millimétriques, les scientifiques ont pu localiser une condensation de gaz et de poussières dont la température est à peine 10 degrés au-dessus du zéro absolu et la masse seulement 2% de celle du Soleil. Ces caractéristiques sont exactement celles attendues pour que se forme une naine brune. La découverte de cette première pré naine brune est publiée dans la revue Science du 6 juillet 2012.

L’instrument MIRI (Mid InfraRed Instrument ou Instrument pour l'InfraRouge Moyen) qui équipera le télescope spatial James Webb (JWST), le successeur de Hubble dont le lancement est prévu fin 2018, vient de partir pour la NASA. MIRI observera l’Univers dans le domaine de l’infrarouge moyen, de 5 à 27 micromètres de longueur d’onde. Il permettra d’explorer la sortie de « l’âge sombre » de l’Univers il y a plus de 13 milliards d’années comme la formation des systèmes planétaires. La livraison à la NASA est l’aboutissement d’une longue période de tests validant le bon fonctionnement de l’instrument et de ses sous-ensembles. MIRI a été conçu et réalisé par un consortium de dix pays européens en collaboration avec les USA. La France à travers le CNES, le CEA, le CNRS, l’Observatoire de Paris, les universités Paris Diderot, UPMC, Paris-Sud et Aix-Marseille, a eu une contribution déterminante à la réalisation de MIRI en fournissant un élément clef : l’imageur MIRIM.

Le détecteur Caméra, construit par l’Irfu, a été mis en place en Septembre 2012. Il est nécessaire pour mesurer des réactions exclusives auprès de Compass au CERN et il permettra l’exploration de la distribution spatiale des constituants des nucléons par la diffusion Compton virtuelle.

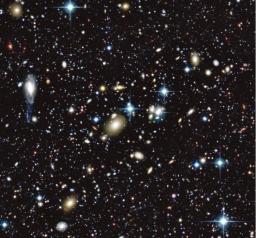

Des astronomes français et canadiens viennent de rendre publique la version finale du grand sondage cosmique du Télescope Canada-France-Hawaii (CFHTLS), un projet d'imagerie multi-couleur unique explorant un volume extrêmement large de l'Univers, et collectant des dizaines de millions de galaxies dont certaines sont distantes de plus de 9 milliards d'années lumière, représentant une véritable mine d'or pour la recherche astrophysique des années à venir. Cette collection remarquable de données, réalisée grâce à la caméra MegaCam construite au CEA, représente une réalisation remarquable du CFHT, inspirant déjà d'autres observatoires à travers le monde. De très nombreux résultats scientifiques ont déjà été publiés sur la base de ces images, incluant la cartographie de la mystérieuse matière sombre à une échelle inédite mais aussi des premières mesures de haute précision des propriétés de la toute aussi mystérieuse énergie sombre.

Les observations du grand relevé CFHTLS ont débuté en 2003 et se sont conclues en 2009. Trois années supplémentaires ont néanmoins été nécessaires pour calibrer avec précision l'énorme volume de données homogènes de haute qualité, plus de 15 000 images obtenues dans cinq canaux couvrant le domaine optique, du bleu au rouge, en incluant le proche ultra-violet et le proche infra-rouge. Les données ont révélé quelques 38 millions d'objets, la plupart étant des galaxies lointaines à divers stages d'évolution, sur une surface de ciel combinée de 155 degrés carrés (800 fois la surface de la pleine Lune telle que perçue dans le ciel).

Une équipe internationale à laquelle ont participé Emanuele Daddi [1] et David Elbaz du Service d'Astrophysique-Laboratoire AIM vient de déterminer la distance d'une des galaxies les plus productrices d'étoiles. Au grand étonnement des astronomes, cette galaxie baptisée HDF850.1 qui produit près de 1000 fois plus d'étoiles que notre galaxie, est située à une très grande distance, dans une région où l'univers est âgé de seulement 1,1 milliards d'années. Elle était invisible sur l'image la plus profonde du ciel visible obtenue par le satellite Hubble mais a été révélée par des observations en ondes millimétriques obtenues à l'interféromètre IRAM du Plateau de Bures (Hautes-alpes). Cette production très précoce d'étoiles dans un univers encore très jeune est une véritable surprise pour les scientifiques. Ces résultats sont publiés dans la revue Nature du 14 juin 2012.

Dans une lettre publiée dans la revue Nature du 26 avril 2012, une équipe internationale d'astrophysiciens incluant des chercheurs du Service d'Astrophysique-Laboratoire AIM du CEA-Irfu révèle pour la première fois que les galaxies plus anciennes de type elliptique ont formé environ trois fois plus d'étoiles que ne le prévoyaient les modèles jusqu'à présent. Cette étude démontre que l'idée d'une formation initiale d'étoiles universelle, identique pour toutes les galaxies, une hypothèse qui est communément utilisée pour interpréter l'évolution des galaxies, ne correspond pas aux galaxies réelles. Ces résultats ont été obtenus dans le cadre du projet Atlas-3D, une étude multi-longueurs d'onde très détaillée de plus de deux cents cinquante galaxies elliptiques et lenticulaires proches.

L’injecteur d’ions légers assemblé à Saclay a fourni jusqu’à 5 mA de protons et de deutérons, en mode continu ou pulsé, qui sont destinés à être injectés dans la cavité RFQ (Radio Frequency Quadrupole) de Spiral2, à Caen.

La construction de l’injecteur a été réalisée par étapes successives, étalées sur deux ans, de sorte que soient mesurées les caractéristiques du faisceau à différentes positions de la « ligne ». Ce travail s’est achevé fin juillet 2012 par des diagnostics à la position exacte qu’occupera le RFQ dans l’injecteur. Les valeurs obtenues ont ensuite été introduites dans un modèle de simulation pour estimer les caractéristiques du faisceau en sortie du RFQ. C’est sans doute la première fois qu’un faisceau de haute intensité est mesuré au point exact d’injection d’un RFQ, puis transporté dans celui-ci par simulation. Le faisceau de sortie de l’injecteur de Spiral2 répond parfaitement au cahier des charges du projet, son passage dans le RFQ devrait être conforme à ce qui est attendu. Cette modélisation, conduite dans des conditions réalistes, valide la conception et la campagne de tests de l’injecteur de Spiral2 réalisées à L’Irfu.

Aujourd’hui, l’injecteur est en cours de démontage avant son transport puis son installation dans le bâtiment de l’accélérateur Spiral2 au Ganil. Les prochaines étapes seront le redémarrage de l’installation et finalement l’injection du faisceau dans la cavité RFQ où les caractéristiques du faisceau à la sortie de celle-ci seront mesurées et comparées avec les résultats prédits par simulation

La 25e conférence internationale bisannuelle de physique des neutrinos vient de se tenir à Kyoto au Japon au début du mois de juin 2012. Les nouvelles mesures du troisième angle de mélange de la matrice des neutrinos, θ13, ont tenu la vedette et c’est une pluie fertile de résultats expérimentaux qui s’est abattue sur la conférence.

L'expérience T2K, à l'arrêt depuis le tremblement de terre de mars 2011, a redémarré sa prise de données à la mi-mars.

"C'est un véritable exploit d'avoir pu remettre en fonctionnement un système aussi complexe dans des conditions difficiles et nous devons tous féliciter nos collègues japonais, et en particulier les équipes chargées des opérations des différents accélérateurs de JPARC." déclare Marco Zito, reponsable de l'expérience T2K à l'Irfu.

Début janvier, ce fut l'heure du premier faisceau, et mi mars, l'expérience a repris le cours de sa vie en enregistrant à nouveau des données.

L'ensemble des accélérateurs avait repris ses activités, à très faible intensité, en décembre 2011. Pour cela, il aura fallu réaligner tous les aimants de l'anneau prinicpal ainsi que corriger la trajectoire du faisceau : le tremblement de terre a en effet provoqué une déformation du bâtiment qui abrite l'accélérateur linéaire.

Depuis, l'intensité sur la cible de T2K bat des nouveaux records avec 190 kW atteint le 12 avril. Cela laisse augurer d'une belle moisson de données pour la conférence Neutrino 2012 qui s'ouvrira à Kyoto en juin.

Avec les annonces récentes des expériences Daya Bay et RENO, la compétition internationale pour mesurer l'angle de mélange theta_13, et au delà la violation de CP dans les neutrinos, entre dans une nouvelle phase très passionnante.

contact Irfu: Marco Zito

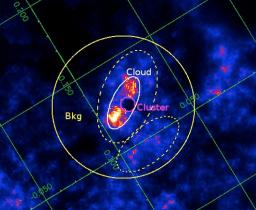

Grâce au satellite européen XMM-Newton d’astronomie en rayons X [1], des chercheurs du CNRS [2] et du CEA [3] ont découvert une nouvelle source de rayons cosmiques. Au voisinage de l’extraordinaire amas des Arches, près du centre de la Voie lactée, ces particules sont accélérées dans l’onde de choc générée par le déplacement à une vitesse d’environ 700 000 km/h de dizaines de milliers de jeunes étoiles. Ces rayons cosmiques produisent alors une émission X caractéristique en interagissant avec les atomes du gaz ambiant. Leur origine diffère de celle des rayons cosmiques découverts il y a tout juste cent ans par Victor Hess, qui sont issus des explosions de supernovæ. Ces résultats sont publiés dans le numéro 546 de la revue Astronomy & Astrophysics.